ログ解析とは?

ログ解析とは?

ウェブサーバーへのアクセスは、/var/log/httpd配下にaccess_logなどの名前で保存

されています。実際にログファイルを見ても何がどうなっているのか解析するだけで大変です。

そこでとても便利なツールがあります。今回紹介するログ解析ツール(webalizer)です。

aptコマンドでインストールできて設定もそれほど複雑ではありません。

何といっても無料ですので試してみるのもいいと思います。

Webalizerのインストール

Webalizerのインストール

・aptコマンドによりWebalizerのインストールを行います。

|

[root@]# apt-get install webalizer

パッケージリストを読みこんでいます... 完了

依存情報ツリーを作成しています... 完了

* webalizer は既に最新バージョンがインストールされています

0 個のアップグレードパッケージ, 0 個の新規パッケージ, 0 個の削除/リプレースパッケージ, 0 個の保留パ

ッケージがあります。

[root@]#

|

すでに最新版がインストールされている場合は、上のようなメッセージがでます。

インストールが必要な場合は、インストールを行って次にすすんでください。

webalizerの設定

webalizerの設定

webalizerをインストール後、webalizerコマンドを実行します。

・webalizerコマンドを実行

|

[root@]# webalizer [return]

Webalizer V2.01-10 (Linux 2.4.22-0vl2.19) Japanese(EUC)

ログファイル ― /var/log/httpd/access_log (clf)

作成ディレクトリ: /home/httpd/html/webalizer

ホスト名 ― 'xxx.ddo.jp'

ヒストリファイルの読み込み... webalizer.hist

以前の実行データを読み込んでいます... webalizer.current

現在の実行データを保存しています... [10/18/2005 23:51:58]

月別レポート作成 ― 2005年 10月

総合レポートの作成

ヒストリ情報の保存...

17673 レコードありました. (12841 行が無効) 処理時間: 3.65 秒, 4841/sec

[root@]#

|

解析状況が表示されて、ログファイルの解析が行われます。

上記解析を実行後に、ブラウザから「https://

ドメイン名/webalizer/」へアクセスしてください。

以下のようなページが表示されるはずです。(標準設定のままでも動作します)

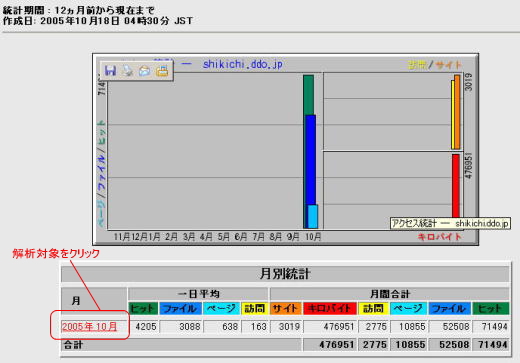

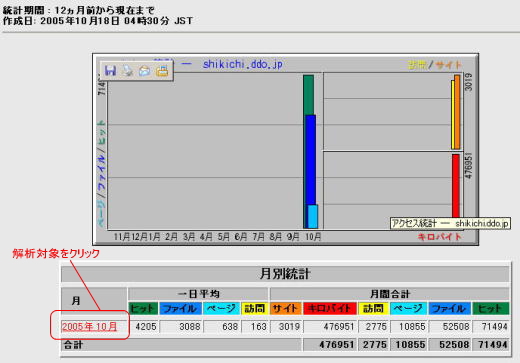

・Webalizerの解析画面

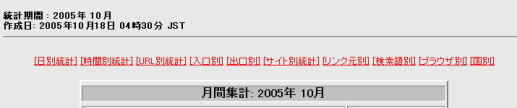

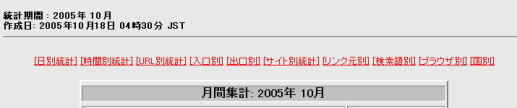

・項目別解析結果(解析対象の月を選択すると項目別に解析結果が表示されます)

これだけでも十分なのですが、集計方法をカスタマイズしたい場合もあります。

webalizerの設定は「/etc/webalizer.conf」ファイルで行います。

設定ファイルの内容を確認してみましょう。

・viエディタで/etc/webalizer.confファイルを開きます。

|

[root@]# vi /etc/webalizer.conf [return]

|

|

<Webalizer.confファイルより抜粋>

#解析対象のログファイルを指定します。(最新ログは"access_log"です)

LogFile /var/log/httpd/access_log

#解析結果の格納先を指定します。(アクセスするURLに影響します。)

OutputDir /home/httpd/html/webalizer

#解析対象のページとみなす拡張子を指定します。(必要に応じて拡張子を追加)

PageType htm*

PageType cgi

・

#解析から除外するサイトを登録します。

#HideSite *mrunix.net

HideSite localhost

・

#解析から除外する拡張子を指定します。

HideURL *.gif

HideURL *.GIF

HideURL *.jpg

・

他にもいろいろと設定できる項目がありますが、解析結果を見てから

不要か必要かを判断してカスタマイズしていきましょう。

※赤文字の部分は環境に合わせて設定してください。

|

|

【注意事項】

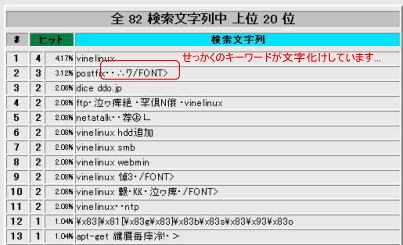

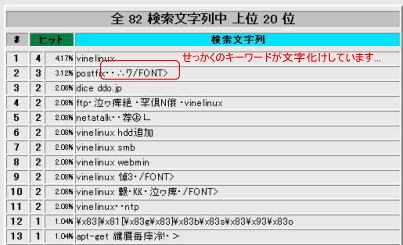

解析結果で「検索文字列」の項目が文字化けしてしまいます。

(文字コードが異なるのが原因です)

これでは、せっかくの検索文字列(キーワード)が見えませんね。

(暫定対策)

とりあえず、「検索文字列」を確認する場合にブラウザのエンコードをUnicode(UTF-8)

に変更して確認します ^^;(他の項目は文字化けしてしまいますが...)

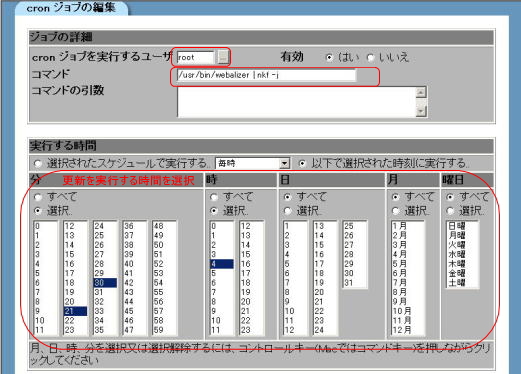

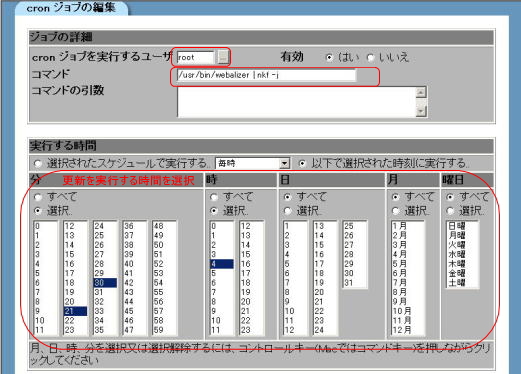

あとは、解析を実施するタイミング(周期)を決めてからcronに登録すると便利です。

・Cronの登録

Webminの管理画面にアクセスします。

「システム→予約済みCron作業→新しいスケジュールのCronジョブを作成」を選択します。

cronジョブを実行するユーザ :「 root 」

コマンド : 「 /usr/bin/webalizer

| nkf -j 」

※

| nkf -jによりCron実行時のメールで文字化けしません。

あとは、実行する時間を指定して保存します。

以上で周期的に自動で解析を行ってくれます。

ブラウザで「https://

ドメイン名/webalizer/」へアクセスすれば、最新の解析結果を確認できます。

ログ解析方法

ログ解析方法

せっかくなので解析ツールを活用してSEO対策?を行います。

※必ずしもアクセスアップするものではありません。私自身SEOの専門家でもありません

のであくまでも参考程度とお考えください。

|

ログ解析方法

●ログ解析から何が分かるのか?

・検索キーワード(検索語別)

検索サイトなどからアクセスした際の検索キーワードを知ることができます。

(ユーザ側が要求しているキーワード)を見つけましょう。

→サイトとして有効なキーワードを見つけてMETAタグに登録します。

<meta name "keywords" content="キーワード1,キーワード2...">

※キーワードはページとの関連性を考慮して選定しましょう^^

・リンク元サイト(リンク元別)

被リンクサイトとのリング状態を知ることができます。

アクセスの多いリンク元サイトは、リンク(情報の共有)が有効に働いています。

ぜひ有益な情報を共有して相互リンクの輪を広げましょう。

当サイトも相互リンク大歓迎です^^;

・ページ単位でのヒット率(URL別統計)

ユーザがどのようなページによくアクセスしているかを知ることができます。

ヒット率が高いページは、ユーザ側で欲しい情報と関連性がある可能性が高いです。

さらに内容を充実させることによりアクセスアップが期待できるかも?

他にもヒット率の推移をみると、行った対策がどうなったかなど目でみてわかります。

結構、意図した方向(アクセスアップ)に繋がったりするとうれしかったりします。

●基本的な考え方

基本的にはユーザが必要とする情報を正確に表示させる仕組みが作れれば良いと考えます。

少なくとも検索サイトもそのようなページを見つけるために日々努力していると思います。

検索したキーワードに対して表示されたページが意図しないものだったりするとがっかりですよね。

SEO対策とまではいかないかもしれませんが、サイトを多くの人に知ってもらい検索サイトに正確な

ページ情報を把握してもらうような構成を検討していくのが一番だと思います。

本当に必要としている人に情報を見てもらい、参考になったと評価してもらえるのがサイトを公開

する上で本当にうれしい事ですから。

そんなサイトを作れるように日々努力していきたいと思います。

|

Copyright(c) 2005, All Rights Reserved.